相关的Diffusion文章: - 一文弄懂 Diffusion Model - 35张图,直观理解Stable Diffusion - 如何简单高效地定制自己的文本作画模型? - Diffusion Model的演进 NeurIPS 2022最佳论文:Imagen - 不需要训练来纠正文本生成图像模型的错误匹配 - Google Brain提出基于Diffusion的新全景分割算法 - 当 TransFormer 遇到 Diffusion

Controlnet的介绍¶

1. 论文信息¶

标题:Adding Conditional Control to Text-to-Image Diffusion Models

作者:Lvmin Zhang, Maneesh Agrawala

原文链接:https://arxiv.org/pdf/2302.05543.pdf

代码链接:https://github.com/lllyasviel/ControlNet

2. 引言¶

大型文本到图像模型的存在让人们意识到人工智能的巨大潜力,这些模型可以通过用户输入简短的描述性提示来生成视觉上吸引人的图像。然而,对于一些长期存在、具有明确问题表述的任务(例如图像处理),我们可能会有一些问题需要回答。这些问题包括:这种基于提示的控制是否满足我们的需求?在特定任务中,这些大型模型能否应用于促进这些特定任务?我们应该建立什么样的框架来处理广泛的问题条件和用户控制?在特定任务中,大型模型能否保留从数十亿张图片中获得的优势和能力?为了回答这些问题,作者们调查了各种图像处理应用,并得出了三个发现。第一个发现是,在特定任务领域中可用的数据规模并不总是与通用图像-文本领域中相同。第二个发现是,对于一些特定任务,需要更加精细的控制和指导,而不仅仅是简单的提示。第三个发现是,在特定任务中,大型模型可能会面临过拟合和泛化能力不足等问题。为了解决这些问题,作者们提出了一种名为ControlNet的框架,该框架可以根据用户提供的提示和控制来生成高质量的图像,并且可以在特定任务中进行微调以提高性能。

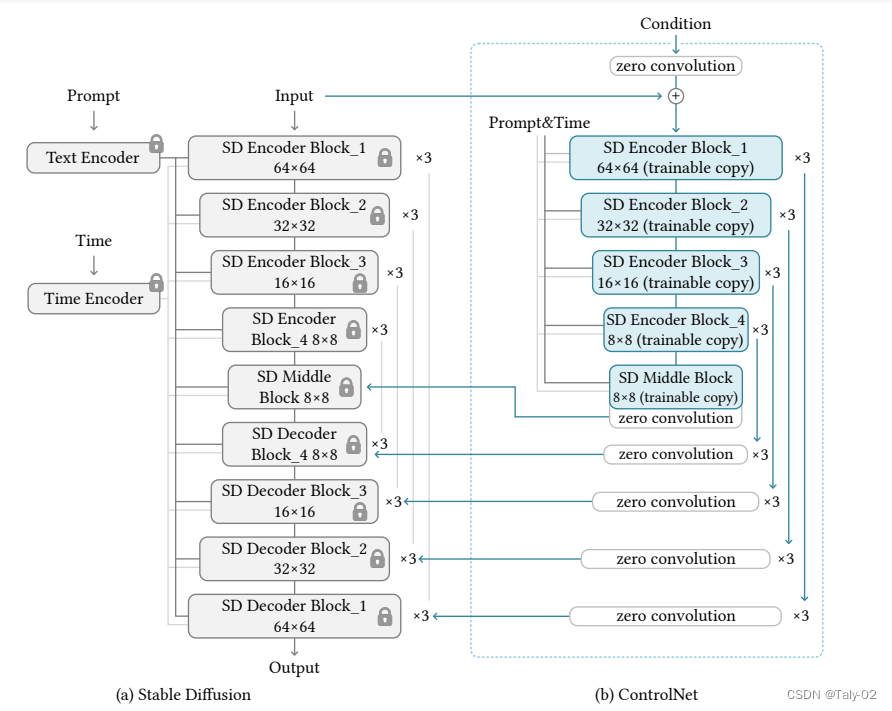

与之相关的主要工作有HyperNetwork和Stable Diffusion。HyperNetwork是一种用于训练神经网络的方法,它可以通过一个小型的神经网络来影响一个更大的神经网络的权重。HyperNetwork已经在图像生成等领域取得了成功,并且已经有多篇相关论文发表。另外,Stable Diffusion是一种用于图像生成和编辑的技术,它可以通过扩散过程来生成高质量、多样化的图像,并且可以通过附加小型神经网络来改变其艺术风格。ControlNet和HyperNetwork之间的相似之处在于它们都可以影响神经网络的行为,从而实现特定任务的目标。具体来说,HyperNetwork使用一个小型的神经网络来影响一个更大的神经网络的权重,从而改变其行为。而ControlNet则是将大型图像扩散模型中的权重克隆到一个“可训练副本”和一个“锁定副本”中,其中锁定副本保留了从数十亿张图像中学习到的网络能力,而可训练副本则在特定数据集上进行训练以学习条件控制。 此外,它们在影响神经网络行为方面的共同点是它们都使用了小型神经网络来对大型神经网络进行控制。这种方法可以使得大型神经网络更加灵活和适应性强,并且可以根据不同任务和条件进行调整和优化。ControlNet与其他相关工作之间的优势主要体现在以下几个方面:

- 控制方式不同:ControlNet通过控制神经网络中的输入条件来影响其行为,而其他相关工作则可能采用不同的控制方式,例如直接修改权重或者使用外部约束等。

- 可解释性更强:ControlNet可以通过可视化输入条件和输出结果之间的关系来解释其行为,从而更好地理解神经网络的内部机制。这对于一些需要可解释性的任务非常重要。

- 适应性更强:ControlNet可以根据不同任务和条件进行调整和优化,从而使得神经网络更加灵活和适应性强。这对于一些复杂、多变的任务非常重要。

- 训练效果更好:ControlNet可以通过使用锁定副本来保留从数十亿张图像中学习到的网络能力,并将其与可训练副本进行结合来进行训练。这种方法可以使得训练效果更好,并且可以避免过拟合等问题。

3. 方法¶

我们尽量少用公式进行表达,主要的技术细节和设定可以参考论文。ControlNet是一种神经网络架构,可以通过特定任务的条件来增强预训练的图像扩散模型。该方法包括几个关键组件,包括预训练模型的“可训练副本”和“锁定副本”,以及一组输入条件,可以用来控制输出。整个过程可以概括如下:

- 克隆预训练模型:ControlNet首先创建了预训练图像扩散模型的两个副本,其中一个是“锁定”的,不能被修改,而另一个是“可训练”的,可以在特定任务上进行微调。 ControlNet使用了一种称为“权重共享”的技术,该技术可以将预训练模型的权重复制到两个不同的神经网络中。这样,在微调可训练副本时,锁定副本仍然保留着从预训练中学到的通用知识,并且可以提供更好的初始状态。 需要注意的是,在克隆预训练模型之前,需要先选择一个适合特定任务的预训练模型,并对其进行必要的调整和优化。这样才能确保克隆出来的模型能够更好地适应特定任务,并取得更好的效果。

- 定义输入条件:ControlNet然后定义了一组输入条件,可以用来控制模型的输出。这些条件可能包括颜色方案、对象类别或其他特定任务参数。 该技术可以将输入条件与预训练模型进行连接,并将其作为额外的输入信息传递给神经网络。这样,在微调可训练副本时,神经网络可以根据这些输入条件来调整输出结果,并更好地适应特定任务。 需要注意的是,在定义输入条件之前,需要先确定哪些参数对于特定任务是最重要的,并选择合适的方式来表示这些参数。例如,在图像分类任务中,可能需要考虑对象类别、颜色和纹理等因素,并选择合适的方式来表示它们。同时,还需要确保这些输入条件能够被有效地传递给神经网络,并且不会对模型性能产生负面影响。

- 训练可训练副本:ControlNet然后使用反向传播和其他标准训练技术,在特定数据集上对可训练副本进行训练。 很自然的就是一个标准的神经网络训练流程。训练可训练副本之前,需要先选择一个适合特定任务的预训练模型,并将其克隆为可训练副本。同时还需要确定哪些输入条件对于特定任务是最重要的,并将其与预训练模型进行连接。

- 合并输出:最后,ControlNet将两个模型副本的输出组合起来,产生一个最终结果,既包含从预训练中学到的通用知识,也包含从微调中学到的特定知识。

4. 实验¶

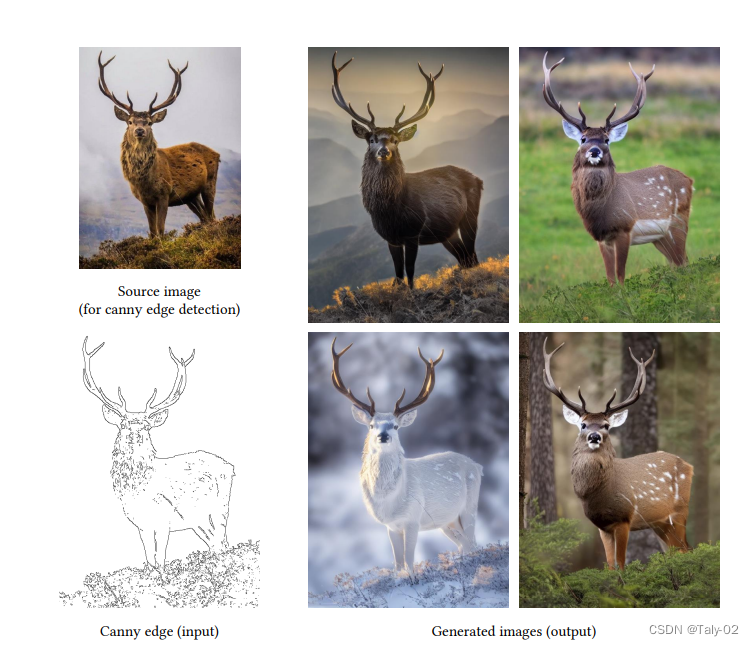

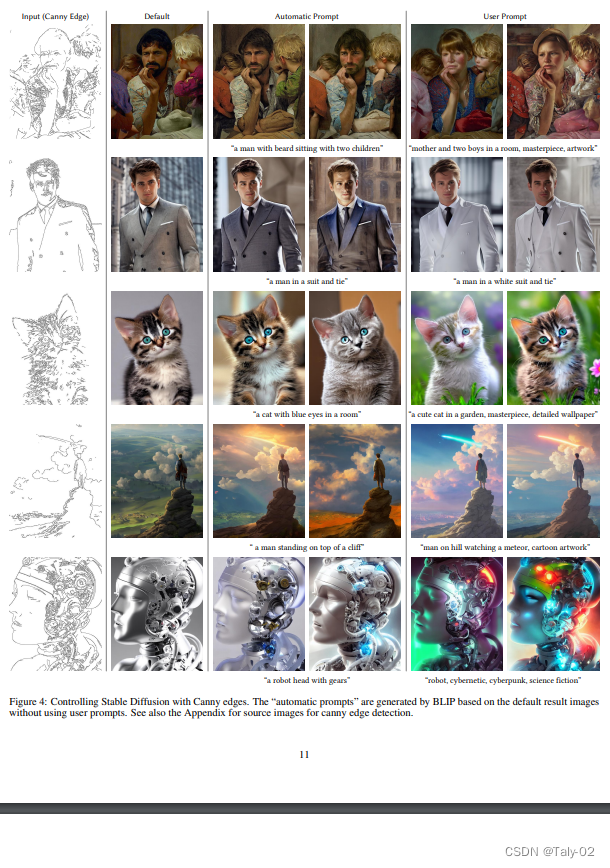

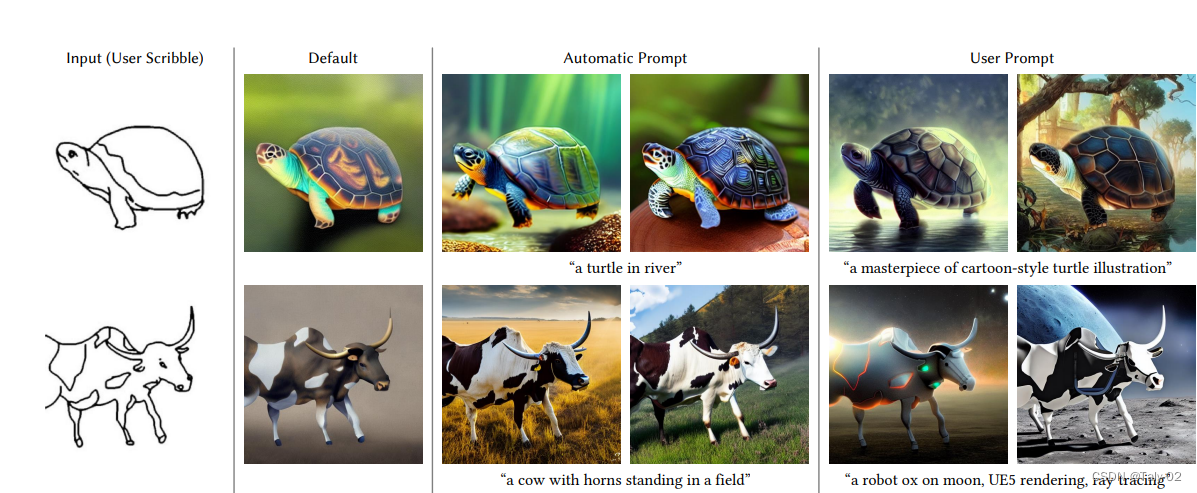

这种方法自然是要看可视化展示的:

5. 结论¶

总的来说,ControlNet是一种新颖的神经网络架构,可以通过微调预训练模型来适应特定任务,并在多个基准数据集上取得了非常好的性能表现。该方法使用条件控制技术将输入条件与预训练模型进行连接,并将其作为额外的输入信息传递给神经网络,从而帮助神经网络更好地理解输入条件,并取得更好的效果。同时,ControlNet还探讨了不同因素对其性能的影响,例如不同输入条件、不同预训练模型和不同微调策略等。实验结果表明,在多个基准数据集上,ControlNet都取得了非常好的性能表现,并且在图像分类、图像生成和图像检索等任务中也有广泛应用。因此,我们相信ControlNet是一种非常有前景和实用价值的神经网络架构,并且在未来会有更广泛的应用。

本文总阅读量次